16 调度(中):主动调度是如何发生的?

上一节,我们为调度准备了这么多的数据结构,这一节我们来看调度是如何发生的。

所谓进程调度,其实就是一个人在做A项目,在某个时刻,换成做B项目去了。发生这种情况,主要有两种方式。

方式一:A项目做着做着,发现里面有一条指令sleep,也就是要休息一下,或者在等待某个I/O事件。那没办法了,就要主动让出CPU,然后可以开始做B项目。

方式二:A项目做着做着,旷日持久,实在受不了了。项目经理介入了,说这个项目A先停停,B项目也要做一下,要不然B项目该投诉了。

主动调度

我们这一节先来看方式一,主动调度。

这里我找了几个代码片段。第一个片段是Btrfs,等待一个写入。Btrfs(B-Tree)是一种文件系统,感兴趣你可以自己去了解一下。

这个片段可以看作写入块设备的一个典型场景。写入需要一段时间,这段时间用不上CPU,还不如主动让给其他进程。

static void btrfs_wait_for_no_snapshoting_writes(struct btrfs_root *root)

{

......

do {

prepare_to_wait(&root->subv_writers->wait, &wait,

TASK_UNINTERRUPTIBLE);

writers = percpu_counter_sum(&root->subv_writers->counter);

if (writers)

schedule();

finish_wait(&root->subv_writers->wait, &wait);

} while (writers);

}

另外一个例子是,从Tap网络设备等待一个读取。Tap网络设备是虚拟机使用的网络设备。当没有数据到来的时候,它也需要等待,所以也会选择把CPU让给其他进程。

static ssize_t tap_do_read(struct tap_queue *q,

struct iov_iter *to,

int noblock, struct sk_buff *skb)

{

......

while (1) {

if (!noblock)

prepare_to_wait(sk_sleep(&q->sk), &wait,

TASK_INTERRUPTIBLE);

......

/* Nothing to read, let's sleep */

schedule();

}

......

}

你应该知道,计算机主要处理计算、网络、存储三个方面。计算主要是CPU和内存的合作;网络和存储则多是和外部设备的合作;在操作外部设备的时候,往往需要让出CPU,就像上面两段代码一样,选择调用schedule()函数。

接下来,我们就来看schedule函数的调用过程。

asmlinkage __visible void __sched schedule(void)

{

struct task_struct *tsk = current;

sched_submit_work(tsk);

do {

preempt_disable();

__schedule(false);

sched_preempt_enable_no_resched();

} while (need_resched());

}

这段代码的主要逻辑是在__schedule函数中实现的。这个函数比较复杂,我们分几个部分来讲解。

static void __sched notrace __schedule(bool preempt)

{

struct task_struct *prev, *next;

unsigned long *switch_count;

struct rq_flags rf;

struct rq *rq;

int cpu;

cpu = smp_processor_id();

rq = cpu_rq(cpu);

prev = rq->curr;

......

首先,在当前的CPU上,我们取出任务队列rq。

task_struct *prev指向这个CPU的任务队列上面正在运行的那个进程curr。为啥是prev?因为一旦将来它被切换下来,那它就成了前任了。

接下来代码如下:

第二步,获取下一个任务,task_struct *next指向下一个任务,这就是继任。

pick_next_task的实现如下:

static inline struct task_struct *

pick_next_task(struct rq *rq, struct task_struct *prev, struct rq_flags *rf)

{

const struct sched_class *class;

struct task_struct *p;

/*

* Optimization: we know that if all tasks are in the fair class we can call that function directly, but only if the @prev task wasn't of a higher scheduling class, because otherwise those loose the opportunity to pull in more work from other CPUs.

*/

if (likely((prev->sched_class == &idle_sched_class ||

prev->sched_class == &fair_sched_class) &&

rq->nr_running == rq->cfs.h_nr_running)) {

p = fair_sched_class.pick_next_task(rq, prev, rf);

if (unlikely(p == RETRY_TASK))

goto again;

/* Assumes fair_sched_class->next == idle_sched_class */

if (unlikely(!p))

p = idle_sched_class.pick_next_task(rq, prev, rf);

return p;

}

again:

for_each_class(class) {

p = class->pick_next_task(rq, prev, rf);

if (p) {

if (unlikely(p == RETRY_TASK))

goto again;

return p;

}

}

}

我们来看again这里,就是咱们上一节讲的依次调用调度类。但是这里有了一个优化,因为大部分进程是普通进程,所以大部分情况下会调用上面的逻辑,调用的就是fair_sched_class.pick_next_task。

根据上一节对于fair_sched_class的定义,它调用的是pick_next_task_fair,代码如下:

static struct task_struct *

pick_next_task_fair(struct rq *rq, struct task_struct *prev, struct rq_flags *rf)

{

struct cfs_rq *cfs_rq = &rq->cfs;

struct sched_entity *se;

struct task_struct *p;

int new_tasks;

对于CFS调度类,取出相应的队列cfs_rq,这就是我们上一节讲的那棵红黑树。

struct sched_entity *curr = cfs_rq->curr;

if (curr) {

if (curr->on_rq)

update_curr(cfs_rq);

else

curr = NULL;

......

}

se = pick_next_entity(cfs_rq, curr);

取出当前正在运行的任务curr,如果依然是可运行的状态,也即处于进程就绪状态,则调用update_curr更新vruntime。update_curr咱们上一节就见过了,它会根据实际运行时间算出vruntime来。

接着,pick_next_entity从红黑树里面,取最左边的一个节点。这个函数的实现我们上一节也讲过了。

p = task_of(se);

if (prev != p) {

struct sched_entity *pse = &prev->se;

......

put_prev_entity(cfs_rq, pse);

set_next_entity(cfs_rq, se);

}

return p

task_of得到下一个调度实体对应的task_struct,如果发现继任和前任不一样,这就说明有一个更需要运行的进程了,就需要更新红黑树了。前面前任的vruntime更新过了,put_prev_entity放回红黑树,会找到相应的位置,然后set_next_entity将继任者设为当前任务。

第三步,当选出的继任者和前任不同,就要进行上下文切换,继任者进程正式进入运行。

if (likely(prev != next)) {

rq->nr_switches++;

rq->curr = next;

++*switch_count;

......

rq = context_switch(rq, prev, next, &rf);

进程上下文切换

上下文切换主要干两件事情,一是切换进程空间,也即虚拟内存;二是切换寄存器和CPU上下文。

我们先来看context_switch的实现。

/*

* context_switch - switch to the new MM and the new thread's register state.

*/

static __always_inline struct rq *

context_switch(struct rq *rq, struct task_struct *prev,

struct task_struct *next, struct rq_flags *rf)

{

struct mm_struct *mm, *oldmm;

......

mm = next->mm;

oldmm = prev->active_mm;

......

switch_mm_irqs_off(oldmm, mm, next);

......

/* Here we just switch the register state and the stack. */

switch_to(prev, next, prev);

barrier();

return finish_task_switch(prev);

}

这里首先是内存空间的切换,里面涉及内存管理的内容比较多。内存管理后面我们会有专门的章节来讲,这里你先知道有这么一回事就行了。

接下来,我们看switch_to。它就是寄存器和栈的切换,它调用到了__switch_to_asm。这是一段汇编代码,主要用于栈的切换。

对于32位操作系统来讲,切换的是栈顶指针esp。

/*

* %eax: prev task

* %edx: next task

*/

ENTRY(__switch_to_asm)

......

/* switch stack */

movl %esp, TASK_threadsp(%eax)

movl TASK_threadsp(%edx), %esp

......

jmp __switch_to

END(__switch_to_asm)

对于64位操作系统来讲,切换的是栈顶指针rsp。

/*

* %rdi: prev task

* %rsi: next task

*/

ENTRY(__switch_to_asm)

......

/* switch stack */

movq %rsp, TASK_threadsp(%rdi)

movq TASK_threadsp(%rsi), %rsp

......

jmp __switch_to

END(__switch_to_asm)

最终,都返回了__switch_to这个函数。这个函数对于32位和64位操作系统虽然有不同的实现,但里面做的事情是差不多的。所以我这里仅仅列出64位操作系统做的事情。

__visible __notrace_funcgraph struct task_struct *

__switch_to(struct task_struct *prev_p, struct task_struct *next_p)

{

struct thread_struct *prev = &prev_p->thread;

struct thread_struct *next = &next_p->thread;

......

int cpu = smp_processor_id();

struct tss_struct *tss = &per_cpu(cpu_tss, cpu);

......

load_TLS(next, cpu);

......

this_cpu_write(current_task, next_p);

/* Reload esp0 and ss1. This changes current_thread_info(). */

load_sp0(tss, next);

......

return prev_p;

}

这里面有一个Per CPU的结构体tss。这是个什么呢?

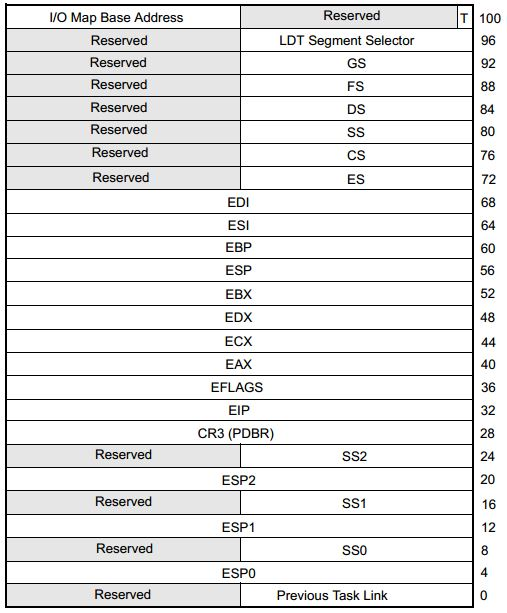

在x86体系结构中,提供了一种以硬件的方式进行进程切换的模式,对于每个进程,x86希望在内存里面维护一个TSS(Task State Segment,任务状态段)结构。这里面有所有的寄存器。

另外,还有一个特殊的寄存器TR(Task Register,任务寄存器),指向某个进程的TSS。更改TR的值,将会触发硬件保存CPU所有寄存器的值到当前进程的TSS中,然后从新进程的TSS中读出所有寄存器值,加载到CPU对应的寄存器中。

下图就是32位的TSS结构。

图片来自Intel® 64 and IA-32 Architectures Software Developer’s Manual Combined Volumes

但是这样有个缺点。我们做进程切换的时候,没必要每个寄存器都切换,这样每个进程一个TSS,就需要全量保存,全量切换,动作太大了。

于是,Linux操作系统想了一个办法。还记得在系统初始化的时候,会调用cpu_init吗?这里面会给每一个CPU关联一个TSS,然后将TR指向这个TSS,然后在操作系统的运行过程中,TR就不切换了,永远指向这个TSS。TSS用数据结构tss_struct表示,在x86_hw_tss中可以看到和上图相应的结构。

void cpu_init(void)

{

int cpu = smp_processor_id();

struct task_struct *curr = current;

struct tss_struct *t = &per_cpu(cpu_tss, cpu);

......

load_sp0(t, thread);

set_tss_desc(cpu, t);

load_TR_desc();

......

}

struct tss_struct {

/*

* The hardware state:

*/

struct x86_hw_tss x86_tss;

unsigned long io_bitmap[IO_BITMAP_LONGS + 1];

}

在Linux中,真的参与进程切换的寄存器很少,主要的就是栈顶寄存器。

于是,在task_struct里面,还有一个我们原来没有注意的成员变量thread。这里面保留了要切换进程的时候需要修改的寄存器。

所谓的进程切换,就是将某个进程的thread_struct里面的寄存器的值,写入到CPU的TR指向的tss_struct,对于CPU来讲,这就算是完成了切换。

例如__switch_to中的load_sp0,就是将下一个进程的thread_struct的sp0的值加载到tss_struct里面去。

指令指针的保存与恢复

你是不是觉得,这样真的就完成切换了吗?是的,不信我们来盘点一下。

从进程A切换到进程B,用户栈要不要切换呢?当然要,其实早就已经切换了,就在切换内存空间的时候。每个进程的用户栈都是独立的,都在内存空间里面。

那内核栈呢?已经在__switch_to里面切换了,也就是将current_task指向当前的task_struct。里面的void *stack指针,指向的就是当前的内核栈。

内核栈的栈顶指针呢?在__switch_to_asm里面已经切换了栈顶指针,并且将栈顶指针在__switch_to加载到了TSS里面。

用户栈的栈顶指针呢?如果当前在内核里面的话,它当然是在内核栈顶部的pt_regs结构里面呀。当从内核返回用户态运行的时候,pt_regs里面有所有当时在用户态的时候运行的上下文信息,就可以开始运行了。

唯一让人不容易理解的是指令指针寄存器,它应该指向下一条指令的,那它是如何切换的呢?这里有点绕,请你仔细看。

这里我先明确一点,进程的调度都最终会调用到__schedule函数。为了方便你记住,我姑且给它起个名字,就叫“进程调度第一定律”。后面我们会多次用到这个定律,你一定要记住。

我们用最前面的例子仔细分析这个过程。本来一个进程A在用户态是要写一个文件的,写文件的操作用户态没办法完成,就要通过系统调用到达内核态。在这个切换的过程中,用户态的指令指针寄存器是保存在pt_regs里面的,到了内核态,就开始沿着写文件的逻辑一步一步执行,结果发现需要等待,于是就调用__schedule函数。

这个时候,进程A在内核态的指令指针是指向__schedule了。这里请记住,A进程的内核栈会保存这个__schedule的调用,而且知道这是从btrfs_wait_for_no_snapshoting_writes这个函数里面进去的。

__schedule里面经过上面的层层调用,到达了context_switch的最后三行指令(其中barrier语句是一个编译器指令,用于保证switch_to和finish_task_switch的执行顺序,不会因为编译阶段优化而改变,这里咱们可以忽略它)。

当进程A在内核里面执行switch_to的时候,内核态的指令指针也是指向这一行的。但是在switch_to里面,将寄存器和栈都切换到成了进程B的,唯一没有变的就是指令指针寄存器。当switch_to返回的时候,指令指针寄存器指向了下一条语句finish_task_switch。

但这个时候的finish_task_switch已经不是进程A的finish_task_switch了,而是进程B的finish_task_switch了。

这样合理吗?你怎么知道进程B当时被切换下去的时候,执行到哪里了?恢复B进程执行的时候一定在这里呢?这时候就要用到咱的“进程调度第一定律”了。

当年B进程被别人切换走的时候,也是调用__schedule,也是调用到switch_to,被切换成为C进程的,所以,B进程当年的下一个指令也是finish_task_switch,这就说明指令指针指到这里是没有错的。

接下来,我们要从finish_task_switch完毕后,返回__schedule的调用了。返回到哪里呢?按照函数返回的原理,当然是从内核栈里面去找,是返回到btrfs_wait_for_no_snapshoting_writes吗?当然不是了,因为btrfs_wait_for_no_snapshoting_writes是在A进程的内核栈里面的,它早就被切换走了,应该从B进程的内核栈里面找。

假设,B就是最前面例子里面调用tap_do_read读网卡的进程。它当年调用__schedule的时候,是从tap_do_read这个函数调用进去的。

当然,B进程的内核栈里面放的是tap_do_read。于是,从__schedule返回之后,当然是接着tap_do_read运行,然后在内核运行完毕后,返回用户态。这个时候,B进程内核栈的pt_regs也保存了用户态的指令指针寄存器,就接着在用户态的下一条指令开始运行就可以了。

假设,我们只有一个CPU,从B切换到C,从C又切换到A。在C切换到A的时候,还是按照“进程调度第一定律”,C进程还是会调用__schedule到达switch_to,在里面切换成为A的内核栈,然后运行finish_task_switch。

这个时候运行的finish_task_switch,才是A进程的finish_task_switch。运行完毕从__schedule返回的时候,从内核栈上才知道,当年是从btrfs_wait_for_no_snapshoting_writes调用进去的,因而应该返回btrfs_wait_for_no_snapshoting_writes继续执行,最后内核执行完毕返回用户态,同样恢复pt_regs,恢复用户态的指令指针寄存器,从用户态接着运行。

到这里你是不是有点理解为什么switch_to有三个参数呢?为啥有两个prev呢?其实我们从定义就可以看到。

#define switch_to(prev, next, last) \

do { \

prepare_switch_to(prev, next); \

\

((last) = __switch_to_asm((prev), (next))); \

} while (0)

在上面的例子中,A切换到B的时候,运行到__switch_to_asm这一行的时候,是在A的内核栈上运行的,prev是A,next是B。但是,A执行完__switch_to_asm之后就被切换走了,当C再次切换到A的时候,运行到__switch_to_asm,是从C的内核栈运行的。这个时候,prev是C,next是A,但是__switch_to_asm里面切换成为了A当时的内核栈。

还记得当年的场景“prev是A,next是B”,__switch_to_asm里面return prev的时候,还没return的时候,prev这个变量里面放的还是C,因而它会把C放到返回结果中。但是,一旦return,就会弹出A当时的内核栈。这个时候,prev变量就变成了A,next变量就变成了B。这就还原了当年的场景,好在返回值里面的last还是C。

通过三个变量switch_to(prev = A, next=B, last=C),A进程就明白了,我当时被切换走的时候,是切换成B,这次切换回来,是从C回来的。

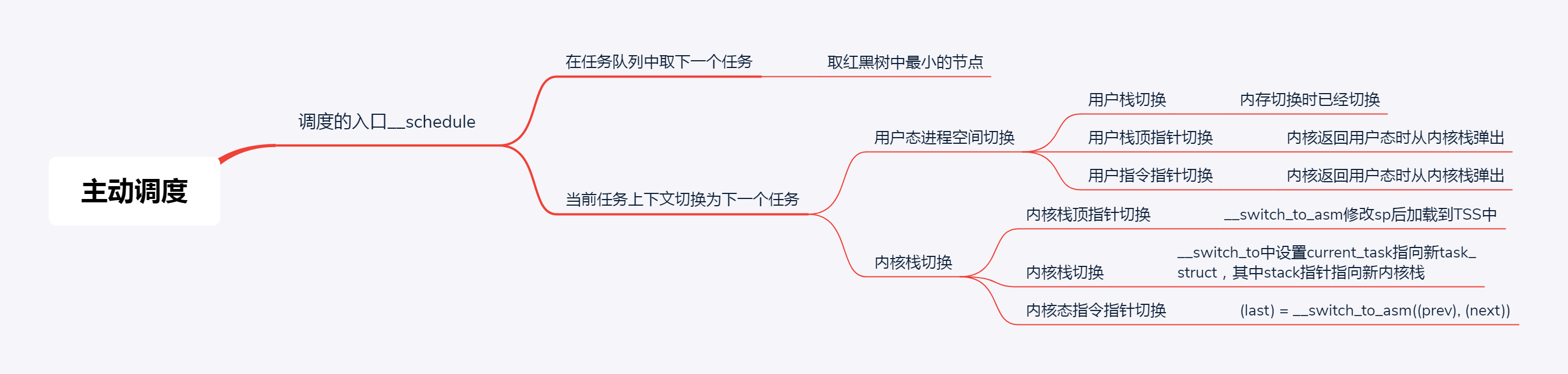

总结时刻

这一节我们讲主动调度的过程,也即一个运行中的进程主动调用__schedule让出CPU。在__schedule里面会做两件事情,第一是选取下一个进程,第二是进行上下文切换。而上下文切换又分用户态进程空间的切换和内核态的切换。

课堂练习

你知道应该用什么命令查看进程的运行时间和上下文切换次数吗?

欢迎留言和我分享你的疑惑和见解,也欢迎你收藏本节内容,反复研读。你也可以把今天的内容分享给你的朋友,和他一起学习、进步。

- 憨人 👍(31) 💬(1)

进程切换需要搞明白:我从哪里来,我要到哪里去

2019-05-17 - 安排 👍(29) 💬(1)

proc文件系统里面可以看运行时间和切换次数,还可以看自愿切换和非自愿切换次数。 老师请教一个问题,A切到B, B切到C,C切到A,当最后切换回A的时候,A要知道自己是从C切换过来的,也就是last,这样做的目的是什么呢?A要对C做什么善后操作吗?

2019-05-03 - 刘強 👍(17) 💬(4)

看了三遍,因为有一些基础,大概明白了。我觉得有个地方很巧妙。当函数返回的时候,由于切换了上下文,包括栈指针,所以一个进程函数执行return返回到了另一个进程,也就是完成了进程的切换。由此也可以看出,cpu也是比较"笨的",它只提供了基本的机制,至于如何利用这种机制,玩出花样,那就是各个操作系统自由发挥了。

2019-05-05 - kdb_reboot 👍(10) 💬(1)

补充一下,看了最后的那张图,感觉切换,就是切内核态的 stack/rsp/pc, 这样下一个任务就能找到在哪执行了,以及继续怎么执行, 而内核态共享一片内存空间,所以不需要mm_switch,切换完了,返回用户态,用户态的stack/rsp/pc都被切换了, 而用户态的内存空间需要单独切换 老师,我理解的对吧?

2019-07-27 - 尚墨 👍(10) 💬(2)

刘老师,每个用户的进程都会被分配一个内核栈吗?

2019-05-08 - 蹦哒 👍(8) 💬(1)

“cpu_init会给每一个 CPU 关联一个 TSS,然后将 TR 指向这个 TSS,然后在操作系统的运行过程中,TR 就不切换了,永远指向这个 TSS” 看到这里,想到了一个设计模式:享元模式(Flyweight Design Pattern)

2020-06-14 - kdb_reboot 👍(8) 💬(1)

看起来ps 里面的TIME就是进程的 cpu runtime吧; 查看上下文切换,可以用cat /proc/x/status

2019-07-27 - kdb_reboot 👍(3) 💬(1)

关于指令指针的讲解,厉害了... 专栏有时候可以反者看, 先看最后总结,然后往上顺藤模块看你的分析 同时在读的书:lkd/ulk, 推荐给大家

2019-07-27 - garlic 👍(3) 💬(1)

通过ps -o etime= -p "$$" 可以 查看,进程的运行时间, 通过/proc/{pid}/status 中的 voluntary_ctxt_switches: nonvoluntary_ctxt_switches: 可以看到主动调度和抢占调度的次数, 也可以单独安装sysstat 使用pidstat -w 查看相关进程的调度信息 https://garlicspace.com/2019/07/20/查看进程运行时间及上下文切换次数/

2019-07-20 - 栋能 👍(3) 💬(5)

我有两个问题,希望老师解解惑: 1.文中说进程切换会从红黑树中找到最左结点,如果不等于当前进程,则切换。但如果更新vruntime之后,树结构还是没变呢,即最左还是等于当前进程,那我当前进程切换不是又没效果了吗?(这点有疑问,是我理解vruntime是公平的,但主动调度一定存在某种情况,如vruntime变化不大,树结构不变的?) 2.在指令指针的恢复与保存这部分内容中,你说A调用__schedule进行切换,在运行到finish_task_switch时进程已经是B了。你觉得这里没有问题,是因为A、B进程都是调用过__schedule方法进行进程切换,最后都执行finish_task_switch就是圆满了。可是进程切换除了主动调用之外,还有时间片用完,如B进程可能并没有调用过__schedule,那如果A进程切换,导致B进程执行finish_task_switch方法,那这是不是个问题呢?本来进程B并不需要执行它的。

2019-07-16 - 一笔一画 👍(3) 💬(2)

老师,我还是对三个参数不解,A->B->C,如果再来一个D怎么办?

2019-05-03 - 奔跑的码仔 👍(2) 💬(2)

"通过三个变量 switch_to(prev = A, next=B,last = C);A 进程就明白了,我当时被切换走的时候,是切换成 B,这次切换回来,是从 C 回来的";这段话中,进程A从进程C切换回来时,进程A内核栈中变量的定义:prev=last=C,netxt=B,由于当前就是在进程A的地址空间里,所以,可以进程A可以说,当年我被切换到进程B,现在,由进程C又切换回来了。

2019-08-26 - 羽 👍(1) 💬(2)

超哥 请教一下为甚需要使用preempt_disable()呢 我搜了一下说是防止死锁 没太明白

2020-06-12 - 雲至 👍(0) 💬(1)

老师能具体编译一个讲下吗?

2019-06-29 - youyui 👍(0) 💬(1)

用户态可以操作寄存器进行cpu上下文切换么

2019-05-28